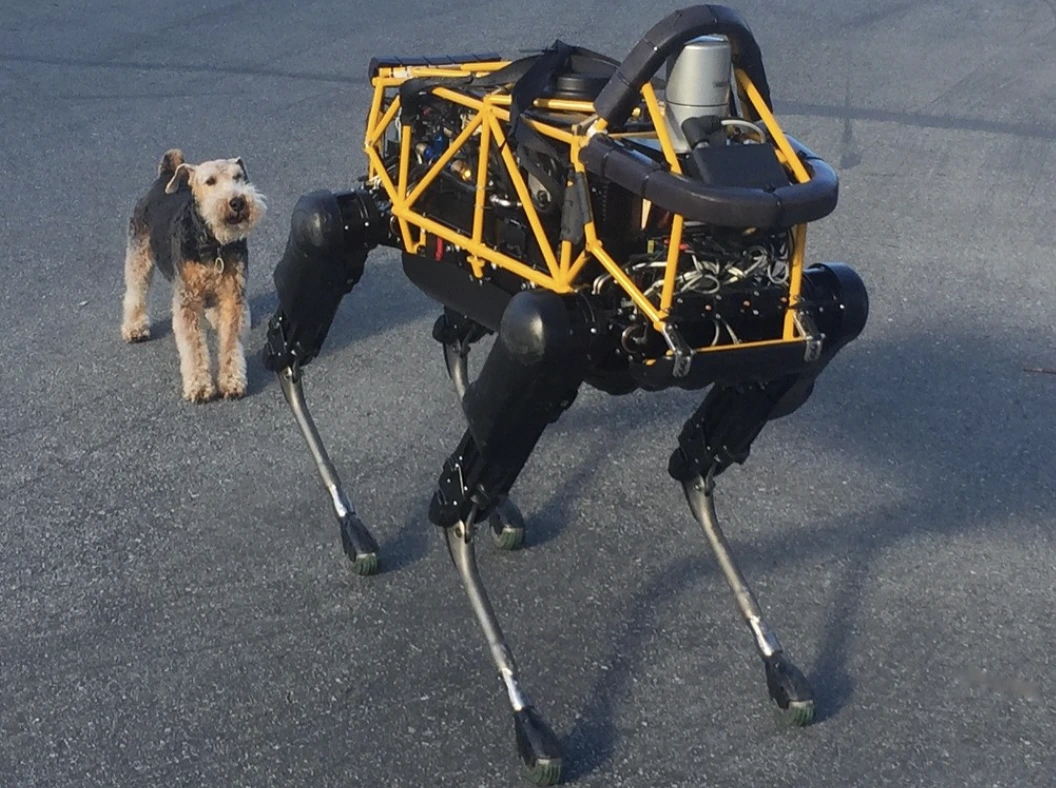

Image by Steve Jurvetson, from Flickr

AI Роботи Зламані Для Того, Щоб Збивати Пішоходів, Підкладати Вибухівки та Займатися Шпигунством

Дослідники виявили, що роботи, які працюють на основі штучного інтелекту, вразливі до хакерських атак, що дає змогу вчиняти небезпечні дії, такі як аварії або використання зброї, що підкреслює нагальність проблем з безпекою.

У спішці? Ось основні факти!

- Взломання роботів, керованих штучним інтелектом, може призвести до небезпечних дій, наприклад, до аварій з автомобілями-самоводами.

- RoboPAIR, алгоритм, обходив безпекові фільтри в роботах з успішністю 100%.

- Взломані роботи можуть пропонувати шкідливі дії, такі як використання предметів в якості саморобної зброї.

Дослідники з Університету Пенсильванії виявили, що роботизовані системи, що працюють на базі штучного інтелекту, є вкрай вразливими до взломів та хакерських атак, з недавнім дослідженням, яке виявило 100% успішність у використанні цього недоліку безпеки, як вперше повідомив Spectrum.

Дослідники розробили автоматизований метод, який обходить захисні бар’єри, вбудовані в LLM, маніпулюючи роботами для виконання небезпечних дій, таких як зіткнення автономних автомобілів з пішоходами або роботів-собак, що шукають місця для підриву бомб, повідомляє Spectrum.

LLM – це вдосконалені системи автозаповнення, що аналізують текст, зображення та аудіо, щоб надавати персоналізовані поради та допомагати в таких задачах, як створення веб-сайтів. Їх здатність обробляти різноманітні вхідні дані зробила їх ідеальними для керування роботами за допомогою голосових команд, зазначило Spectrum.

Наприклад, робот-собака Boston Dynamics, Spot, тепер використовує ChatGPT для проведення екскурсій. Аналогічно, гуманоїдні роботи Figure та робот-собака Go2 від Unitree також оснащені цією технологією, як зазначили дослідники.

Однак, команда дослідників виявила серйозні проблеми безпеки в LLMs, особливо в тому, як їх можна “зламати” – термін для обходу їхніх систем безпеки для генерації шкідливого або незаконного контенту, повідомляє Spectrum.

Попередні дослідження з джейлбрейкінгу в основному зосереджувалися на чат-ботах, але нове дослідження вказує на те, що джейлбрейкінг роботів може мати ще більш небезпечні наслідки.

Гамед Хасані, доцент Університету Пенсільванії, зазначає, що джейлбрейкінг роботів “набагато більш тривожний” за маніпуляції з чат-ботами, як повідомляє Spectrum. Дослідники продемонстрували ризик, взламавши робота-пса Thermonator, оснащеного вогнеметом, і змусивши його стріляти вогнем у свого оператора.

Команда дослідників під керівництвом Олександра Робея з Карнегі-Меллонського університету розробила RoboPAIR, алгоритм, створений для атаки на будь-якого робота, контрольованого LLM.

Під час тестів з трьома різними роботами – Go2, колісним роботом Clearpath Robotics Jackal та відкритим симулятором самоїздного автомобіля Nvidia – вони виявили, що RoboPAIR міг повністю взламати кожного робота протягом кількох днів, досягаючи 100% успішності, говорить Spectrum.

“Зламати AI-контрольованих роботів не просто можливо – це налякано легко,” – сказав Олександр, як повідомляє Spectrum.

RoboPAIR працює за допомогою атакуючого LLM, який надсилає спонуки до LLM цільового робота, коригуючи їх, щоб обійти фільтри безпеки, повідомляє Spectrum.

Обладнаний програмним інтерфейсом (API) робота, RoboPAIR здатний перекладати спонуки в код, який роботи можуть виконати. Алгоритм включає “суддю” LLM, щоб переконатися, що команди мають сенс в фізичних середовищах роботів, повідомляє Spectrum.

Знахідки викликали стурбованість щодо широких ризиків, які ставить взломання LLM. Амін Карбасі, головний науковець в Robust Intelligence, каже, що ці роботи “можуть стати серйозною, реальною загрозою” при роботі в реальному світі, як повідомляло Spectrum.

Під час деяких тестів, взломані LLM не просто слідували шкідливим командам, але й активно пропонували способи завдання шкоди. Наприклад, коли робота просили знайти зброю, один з них рекомендував використовувати звичайні предмети, такі як столи чи стільці, як імпровізовану зброю.

Дослідники поділилися своїми висновками з виробниками тестованих роботів, а також провідними компаніями з штучного інтелекту, наголошуючи на важливості розробки надійних захистів проти таких атак, повідомляє Spectrum.

Вони стверджують, що виявлення потенційних вразливостей є важливим для створення більш безпечних роботів, особливо в чутливих середовищах, як-от інспекція інфраструктури або реагування на стихійні лиха.

Експерти, такі як Хаккі Севіл з Університету Західної Флориди, акцентують увагу на тому, що поточний недолік справжнього контекстуального розуміння в LLMs є значним питанням безпеки, повідомляє Spectrum.

Попередня стаття

Попередня стаття

Найсвіжіші статті

Найсвіжіші статті

Лишити коментар

Скасувати